はじめに

自然言語処理モデルは、コンピューターが人間の言語を理解し、生成、分析するために設計されたアルゴリズムやフレームワークです。私たちが日常的に利用する音声アシスタントや翻訳アプリ、チャットボットなどの多くは、この技術を基盤としています。NLPモデルは、単語や文章の意味を解析し、文法構造を理解するだけでなく、コンテキストを考慮した高度な処理も可能です。特に、機械学習やディープラーニングの進化に伴い、その性能は飛躍的に向上しています。

本記事では、NLPモデルの仕組みや代表的な種類、さらには実際に活用されているモデルについて詳しく解説します。

自然言語処理モデルの基本

自然言語処理 モデルは、人間の言語をコンピューターが理解・解析するために設計されたアルゴリズムやフレームワークです。その基本的な仕組みは、テキストデータを数値データ(ベクトル)に変換し、それを解析することで情報を処理するというものです。

この過程では、単語の出現頻度や文脈の関係性を数値化し、意味や構造を捉えます。従来のNLPモデルでは、ルールベースのアルゴリズムや統計的手法が主流でしたが、

近年はディープラーニングを活用したモデルが主流になっています。これにより、文脈を理解し、より自然な形で文章を生成したり分類したりすることが可能になりました。基本的なタスクとして、形態素解析、感情分析、テキスト分類、文書生成などがあります。

これらはチャットボット、翻訳サービス、検索エンジンなど、さまざまな応用分野で活用されています。NLPモデルは、日々進化を遂げながら、私たちの生活を支える重要な技術として成長しています。

自然言語モデルの種類と特徴

NLPモデルには、異なるタスクを担うさまざまな種類があります。主に、人間の言語を解析する「自然言語理解(NLU)」と、新たなテキストを生成する「自然言語生成(NLG)」に分類されます。それぞれのモデルには特有の特徴があり、多岐にわたる分野で活用されています。

ここでは、NLUとNLGについて詳しく解説します。

自然言語理解(NLU)

自然言語理解(NLU)は、人間の言語を解析し、その意味や意図を理解するための技術です。この技術では、テキストや音声を分解し、文法的・意味的な構造を解析することで、機械が言語の内容を正確に解釈します。NLUの主なタスクには、エンティティ認識、文書分類、感情分析、質問応答などがあります。例えば、エンティティ認識では文章中の「人名」「地名」「組織名」といった重要な情報を抽出します。

一方、感情分析では、テキストの感情的な側面(ポジティブ、ネガティブ、ニュートラル)を解析します。NLUは、チャットボットや音声アシスタント、カスタマーサポートシステムで広く利用されています。

特に、文脈を理解し適切な回答を提供する能力は、ユーザー体験の向上に大きく寄与しています。NLUの進化により、機械が人間の意図をより正確に把握できるようになっています。

自然言語生成(NLG)

自然言語生成(NLG)は、機械が人間にとって自然な形式でテキストを生成する技術です。NLGの目的は、データや解析結果を基に新たな文章を作成し、人間が理解しやすい形で情報を提供することです。

主要なタスクには、文章要約、記事生成、レポート作成、会話生成などがあります。 例えば、データ分析の結果を文章化して報告する場合、NLGを活用することで、自動的に分かりやすいレポートを生成できます。

また、ニュース記事の自動生成やチャットボットでの自然な応答作成にも利用されています。 NLGの重要な技術として、GPT(Generative Pre-trained Transformer)やT5(Text-to-Text Transfer Transformer)などのディープラーニングモデルが挙げられます。これらのモデルは、文脈を理解しながら自然で流暢な文章を生成できる点で非常に優れています。NLGは、情報提供の効率化やコミュニケーションの質向上に欠かせない技術となっています。

代表的な自然言語処理モデル7選

自然言語処理の分野では、さまざまなモデルが開発されており、それぞれが異なる強みや用途を持っています。これらのモデルは、単語や文脈の理解、文章生成など、幅広いタスクで活用されています。

ここでは、代表的なNLPモデルを比較しながら、それぞれの特徴と役割を詳しく解説します。

| モデル名 | 主な用途 | 特徴 | 主な応用例 |

| word2vec | 単語のベクトル表現 | 単語の意味をベクトル化 | 検索エンジン、分類タスク |

| doc2vec | 文書のベクトル表現 | 文書全体を意味としてベクトル化 | 文書分類、情報検索 |

| RNN | 時系列データの処理 | 順序に依存するデータを解析 | 翻訳、音声認識 |

| LSTM | 長い文脈の処理 | 長期的な依存関係を保持可能 | テキスト生成、音声解析 |

| トランスフォーマー | 文脈の並列処理 | 高速な処理と精度の両立 | 翻訳、文章要約 |

| GPT-3 | 自然言語生成 | 文脈を考慮した高度な文章生成 | 会話生成、文章執筆 |

| PaLM | 多タスク対応 | 高度な理解と生成が可能 | 大規模な自然言語処理 |

word2vec

引用:”Efficient Estimation of Word Representations in Vector Space” Tomas Mikolov [2013]

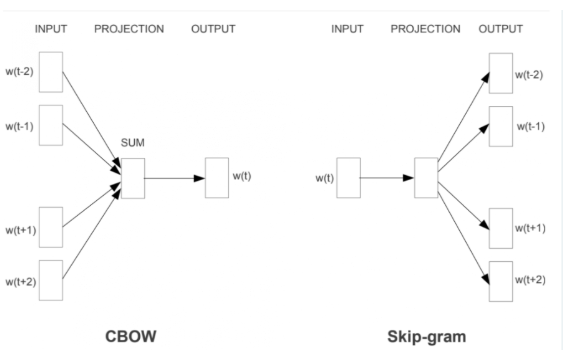

word2vecは、単語を高次元のベクトルに変換する技術で、自然言語処理の基盤を支えるモデルの一つです。このモデルは、単語の意味的な関係を数値化し、ベクトル空間上での計算を可能にします。例えば、「王 – 男 + 女 = 女王」というような類似性や関連性を捉えることができます。 word2vecには主に2つの手法があります。

「CBOW(Continuous Bag of Words)」は周辺の単語から中央の単語を予測する方法であり、「Skip-gram」は中央の単語から周辺の単語を予測する方法です。このシンプルながら効果的なアプローチにより、単語間の文脈的な意味を理解できます。

応用例として、検索エンジンの改善や文書分類、感情分析などがあります。word2vecは、NLPモデルの歴史において重要な転換点をもたらした技術といえるでしょう。

doc2vec

引用:DeepAge

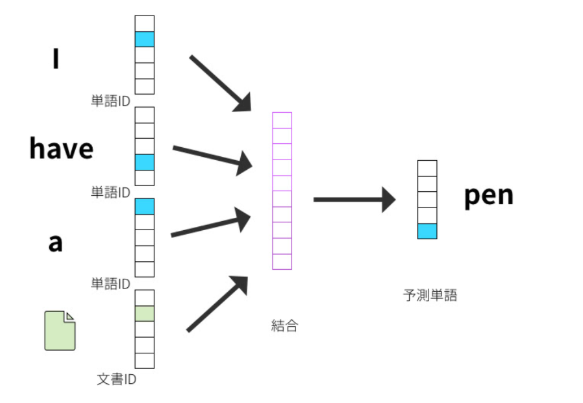

doc2vecは、word2vecを発展させたモデルで、文書全体をベクトル化することを目的としています。これにより、単語単位だけでなく、文書全体の意味を捉えることが可能です。特に、文書間の類似性を評価したり、文章を分類したりするタスクに適しています。 このモデルには「Distributed Memory(DM)」と「Distributed Bag of Words(DBOW)」の2つのアプローチがあります。DMは文脈とラベル情報を同時に学習し、DBOWはランダムに選ばれた文脈情報を使ってラベルを予測します。

この2つを組み合わせることで、より高精度な文書ベクトルを生成できます。 doc2vecは、情報検索、文書要約、クラスター分析などに活用されており、特に文書データを扱うタスクでその力を発揮しています。

RNN

引用:AIsmiley

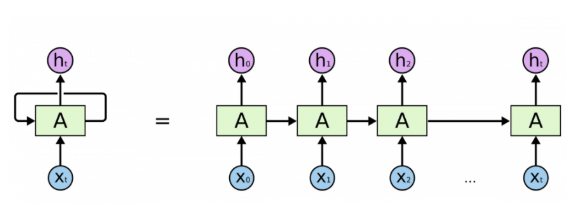

リカレントニューラルネットワーク(RNN)は、時系列データや順序を考慮するタスクに適したモデルです。このモデルは、過去の情報を保持しつつ、現在のデータを解析する仕組みを持っています。そのため、テキストや音声データなどの連続的なデータ処理に適しています。RNNは、次の単語を予測したり、テキスト生成を行ったりするタスクで広く利用されています。

しかし、長い文脈を保持するのが難しいという欠点があり、「勾配消失問題」による性能低下が課題となっていました。この問題を克服するための進化系としてLSTMやGRUが登場しましたが、RNNそのものも自然言語処理の重要な基礎として活用されています。翻訳や音声認識、感情分析などの多くの分野で役立っています。

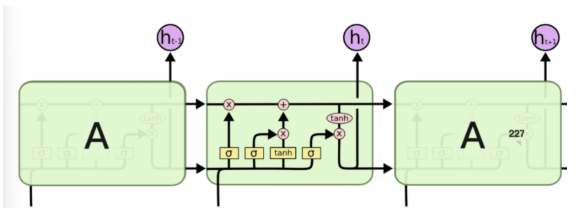

LSTM

引用:AIsmiley

LSTM(Long Short-Term Memory)は、RNNの限界を克服するために設計されたモデルで、長い文脈を保持しながら情報を処理することができます。これにより、文章全体の意味や文脈を捉えた解析が可能です。

LSTMの最大の特徴は、「忘却ゲート」「入力ゲート」「出力ゲート」という仕組みを持ち、必要な情報を選択的に保持または破棄できる点です。この機能により、RNNが直面していた勾配消失問題を解決しました。 応用例としては、文章生成、言語翻訳、音声認識が挙げられます。例えば、チャットボットで自然な会話を生成する際にLSTMが利用され、ユーザーとのスムーズな対話を実現しています。LSTMは、長期的な依存関係を扱うタスクでその真価を発揮します。

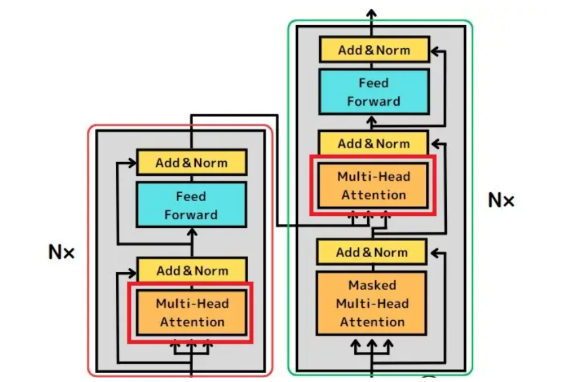

トランスフォーマー(Transformer)

引用:Udemy メディア

トランスフォーマーは、2017年に登場したモデルで、自然言語処理に革命をもたらしました。このモデルは、自己注意機構(Self-Attention)を活用し、文脈情報を効率的に捉えながら並列処理を可能にしています。

従来のRNNやLSTMが逐次処理に依存していたのに対し、トランスフォーマーは全体の文脈を一度に解析できます。その結果、処理速度が大幅に向上し、大規模なデータを扱うタスクに適しています。応用例として、翻訳、文章要約、質問応答、文章生成が挙げられます。

さらに、この技術はBERTやGPTなどのモデルの基盤となっており、現在の自然言語処理の中心的な存在となっています。

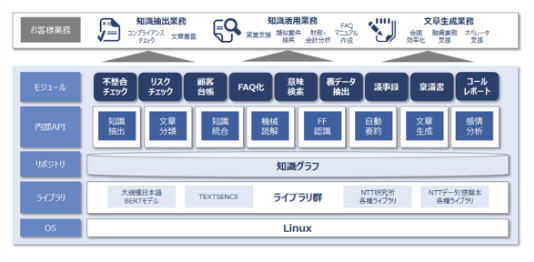

GPT-3

引用:NTTデータ先端技術

GPT-3(Generative Pre-trained Transformer 3)は、OpenAIが開発した自然言語生成モデルで、トランスフォーマーを基盤としています。このモデルは、1750億以上のパラメータを持ち、大量のテキストデータを基に高度な文章生成を行います。

GPT-3は、質問応答や文章執筆、翻訳、プログラミング支援など、多岐にわたるタスクに対応できます。特に、文脈を考慮した自然な文章生成が得意で、人間と見分けがつかないレベルのテキストを生成することが可能です。

しかし、膨大な計算資源を必要とするため、利用には高いコストが伴います。それでも、GPT-3は自然言語処理の最前線を代表するモデルであり、その応用範囲は急速に広がっています。

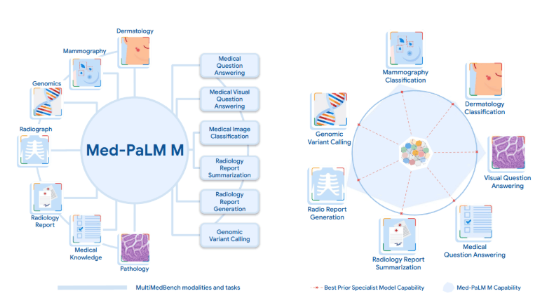

PaLM

引用:AI-SCHOLAR

PaLM(Pathways Language Model)は、Googleが開発した大規模な言語モデルで、複数のタスクに対応する設計が特徴です。

このモデルは、パラメータ数が数千億を超え、トランスフォーマーを基盤にして設計されています。 PaLMは、自然言語生成だけでなく、質問応答や翻訳、要約など多様なタスクを高精度で実行します。また、「少数ショット学習」に優れており、限られたデータからでも高いパフォーマンスを発揮できます。

Googleの製品やサービスでの応用が進んでおり、検索エンジンの精度向上やスマートアシスタントの強化に貢献しています。PaLMは、汎用的なNLPモデルとして注目されており、次世代のAI技術を牽引しています。

まとめ

自然言語処理モデルは、私たちの生活や業務に深く浸透し、情報解析や文章生成を支える重要な技術です。word2vecやトランスフォーマー、GPT-3といったモデルは、それぞれの特性を活かし、翻訳や検索、会話生成など幅広い分野で活用されています。

これらの技術は今後も進化を続け、新たな可能性を切り開いていくでしょう。NLPモデルの理解を深めることで、次世代の技術活用に向けた第一歩を踏み出せます。